MongoDB proporciona una API para los modelos de incrustación y reevaluación de clase mundial de Voyage IA. Utiliza los modelos de Voyage AI con otras partes de tu pila de IA, incluyendo bases de datos vectoriales y grandes modelos de lenguaje (LLM), para compilar aplicaciones listas para producción con una búsqueda y recuperación de IA precisas.

Edificio de inicio

Utilice los siguientes recursos para comenzar:

Cree una clave API, genere sus primeras incorporaciones y cree una aplicación RAG.

Aprenda a administrar sus claves API en MongoDB Atlas.

Explora la especificación API.

Modelos de IA de viajes

Los modelos de integración y reordenamiento de Voyage AI son de vanguardia en cuanto a precisión de recuperación. Para obtener más información sobre los modelos, consulte Descripción general de los modelos.

viaje-4-grande

La mejor calidad de recuperación multilingüe y de uso general. Todos los modelos de la serie 4 comparten el mismo espacio de incrustación.

contexto de viaje3

Incrustaciones de fragmentos contextualizados optimizados para una calidad de recuperación multilingüe y de propósito general.

viaje-multimodal-3.5

Modelo de incrustación multimodal enriquecido que puede vectorizar texto intercalado y datos visuales, como capturas de pantalla de archivos PDF, diapositivas, tablas, figuras, videos y más.

rerank-2.5

Nuestro reranker generalista optimizado para la calidad con seguimiento de instrucciones y soporte multilingüe.

Casos de uso

Los modelos de inteligencia artificial de Voyage admiten los siguientes casos de uso:

Utilice la búsqueda semántica para recuperar información contextualmente relevante.

Implemente RAG para fundamentar los LLM en sus datos y reducir las alucinaciones.

Mejor juntos

Aproveche Voyage AI con MongoDB Vector Search e integraciones de IA para optimizar el desarrollo de sus aplicaciones de IA.

Combine los modelos de IA de Voyage con MongoDB Vector Search para crear aplicaciones de IA listas para producción.

Integre con LangChain, LlamaIndex y otros marcos de IA populares.

Conceptos clave

- modelo de incrustación

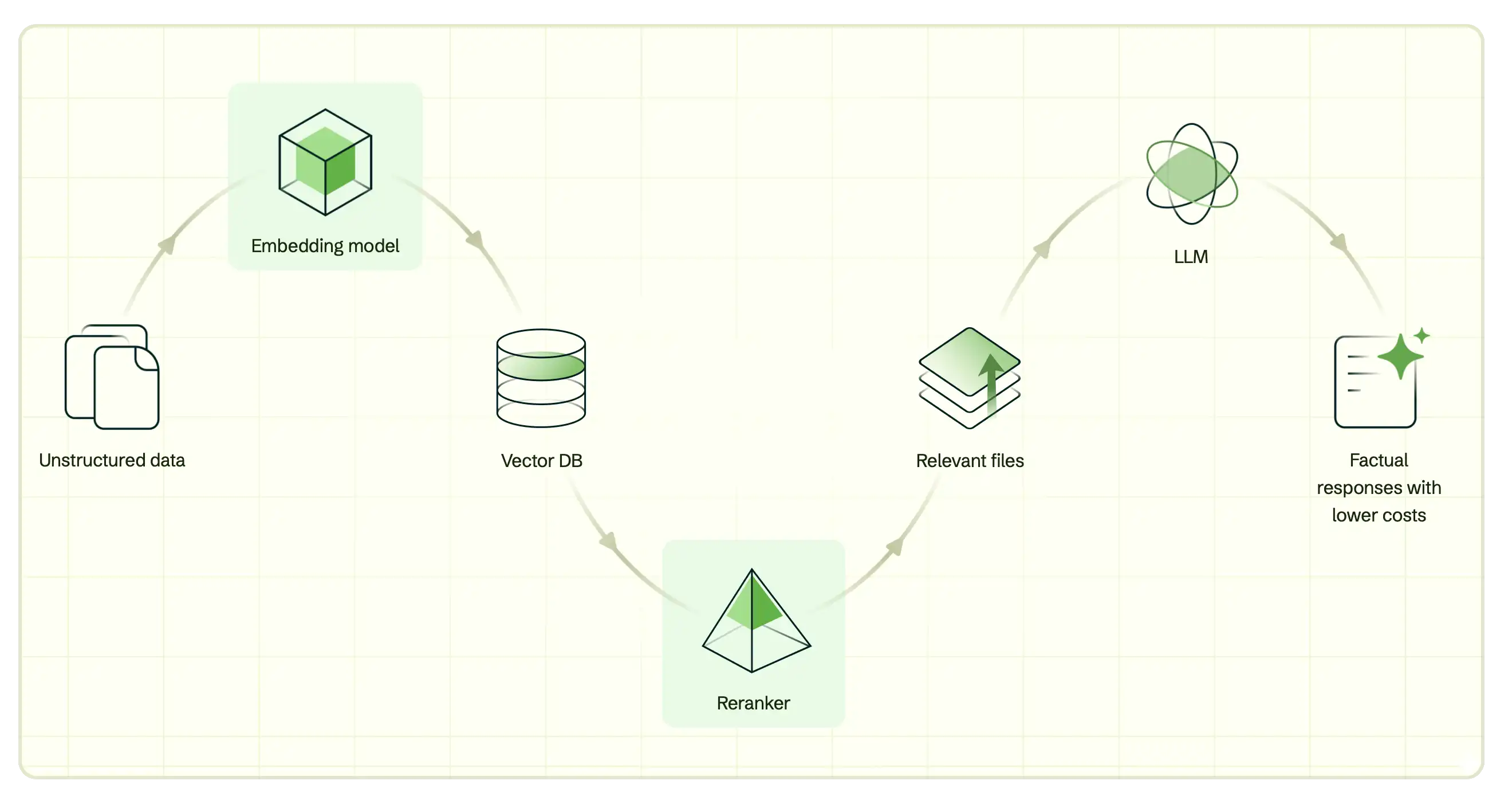

- Los modelos de incrustación son algoritmos que convierten datos en incrustaciones vectoriales que capturan su significado semántico o subyacente. Estos vectores permiten la búsqueda vectorial y sirven como elementos esenciales para la generación aumentada por recuperación (RAG), el enfoque predominante para desarrollar aplicaciones de IA fiables.

- reranker

- Losrerankers son algoritmos que evalúan la relevancia entre una consulta de búsqueda y los resultados. Los rerankers ayudan a refinar los resultados iniciales reordenando los documentos según su relevancia, lo que genera un subconjunto de resultados más preciso.

- embeddings vectoriales

- Una incrustación vectorial es una matriz de números, donde cada dimensión representa una característica o atributo diferente de los datos. Los vectores pueden usarse para representar cualquier tipo de datos, desde texto, imágenes y vídeo hasta datos no estructurados. Las incrustaciones vectoriales se crean pasando los datos a través de un modelo de incrustación y se pueden almacenar en una base de datos compatible con incrustaciones vectoriales, como MongoDB.

- Búsqueda vectorial

- La búsqueda vectorial es el método de búsqueda que impulsa la búsqueda semántica y RAG. Al medir la distancia entre vectores, se puede determinar la similitud semántica entre diferentes puntos de datos. Esto permite obtener resultados de búsqueda relevantes al comparar la consulta vectorizada con las incrustaciones vectoriales. Los modelos de Voyage AI se pueden usar con cualquier solución y base de datos de búsqueda vectorial, pero se integran perfectamente con MongoDB Vector Search y MongoDB Atlas.

- RAG

- La generación aumentada por recuperación (RAG) es una arquitectura que se utiliza para aumentar los modelos lingüísticos grandes (LLM) con datos adicionales para que puedan generar respuestas más precisas. Para obtener más información, consulte RAG con Voyage AI.

- tokens

- En el contexto de los modelos de incrustación y los LLM, los tokens son las unidades fundamentales de texto, como palabras, subpalabras o caracteres, que el modelo procesa para crear incrustaciones o generar texto. Los tokens son el método de facturación por el uso de los modelos de incrustación y los LLM.

- límites de velocidad

- Los límites de velocidad son restricciones impuestas por los proveedores de API sobre la cantidad de solicitudes que un usuario puede realizar en un período de tiempo específico, a menudo medidos en tokens por minuto (TPM) o solicitudes por minuto (RPM). Estos límites garantizan un uso justo, previenen el abuso y mantienen la estabilidad y el rendimiento del servicio para todos los usuarios.